Искусственный интеллект: большая возможность или большая угроза?

2025-05-08

Ответ на этот вопрос становится все менее очевидным и хотя время для выбора правильного направления развития еще есть, оно быстро сокращается. При этом главную угрозу несут не технологии, а, как это чаще всего бывает, человеческий фактор.

Нужен ли новый «Манхэттенский проект»?

Поводом к размышлениям стала большая статья, которую недавно опубликовал бывший руководитель Google Эрик Шмидт в соавторстве с Александром Вангом, основателем Scale AI и Дэном Хендриксом, директором Центра безопасности ИИ. В материале Superintelligence Strategy («Стратегия сверхразума») который есть в открытом доступе, эксперты рассуждают о том, что искусственный интеллект, помимо явных преимуществ и угроз, может нести и скрытые риски.

В первую очередь, если мы говорим о развитии технологий на государственном уровне — к чему сегодня стремятся многие страны. Напомним, что Эрик Шмидт занимал высшие посты в Google и Alphabet Inc. с 2001 по 2017 годы, а затем еще некоторое время оставался там же в роли технического консультанта. С 2025 года Шмидт является генеральным директором Relativity Space, компании по производству аэрокосмической техники.

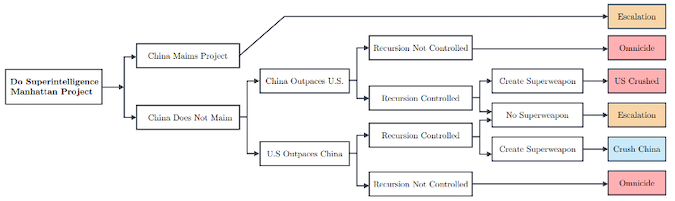

Это человек, обладающий глубокими знаниями и опытом в области ИТ и он считает, что стремительное развитие технологий ИИ, которое мы наблюдаем сегодня, может привести к неконтролируемой «гонке вооружений», которая в итоге дорого обойдется всем нам. Рассуждая о роли AI, эксперт сравнивает его значение с разработкой технологий расщепления атомного ядра, которые наряду с огромными преимуществами дали миру еще и самое опасное оружие в истории. По словам Шмидта, США сегодня стоит на пороге создания очередного «Манхэттенского проекта», на этот раз в области искусственного интеллекта, который может обеспечить стране безусловное глобальное доминирование в данной сфере. Однако такие попытки, продолжает Шмидт, спровоцируют другие страны, в первую очередь Китай, на собственные аналогичные программы, а, главное, на кибератаки и саботаж американских технологий.

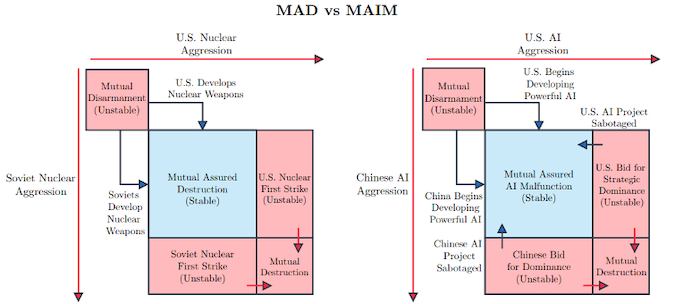

Авторы статьи даже вводят термин Mutual Assured AI Malfunction, MAIM (гарантированное взаимное несрабатывание ИИ), по аналогии с Mutual Assured Destruction (доктрина гарантированного взаимного уничтожения). MAIM означает, что наиболее опасные проекты в области искусственного интеллекта могут быть выведены из строя противником в решающий момент, причем такими возможностями обладают как США, так и Китай. Оба государства все еще сильно зависят в области AI-технологий от цепочек поставок из других стран и скрытый саботаж возможен на самых различных этапах.

Избежать эскалации, по мнению экспертов, поможет разработка механизмов контроля над цепочками поставок в сфере ИИ, в частности, предлагается наладить контроль над ускорителями вычислений (GPU/TPU) с той же строгостью и ответственностью, как и в случае опасных химических или радиоактивных материалов.

Другим возможным путем снижения напряжения может стать отказ от доктрины безусловного доминирования, а также международный контроль над разработкой ИИ-технологий. Все эти рекомендации носят, конечно, умозрительный характер, но повод по которому он даются, вполне осязаемый, потому что технологии искусственного интеллекта все больше влияют не только на повседневную жизнь, но и на баланс сил на международной арене. Поэтому вопрос контроля здесь может встать очень остро уже в самое ближайшее время и к тому моменту хорошо бы иметь готовый ответ на этот вопрос.

Ловушка «петли деградации»

Влияние ИИ на международные отношения и доминирование стран — это высокие материи, нам гораздо важнее то, как искусственный интеллект влияет на каждого прямо сейчас. А влияние это есть и оно растет. Недавнее масштабное исследование, которое провели MIT Media Lab и OpenAI показало, что люди склонны к формированию эмоциональной привязанности к чат-боту, который все чаще воспринимается, как настоящий собеседник. В исследовании, которое охватило тысячу человек и длилось около месяца, рассматривались проявления т.н. «аффективного использования» — случаев, когда пользователи проявляют эмпатию или ищут поддержки у искусственного интеллекта, как если бы это был живой собеседник. Процент людей, у которых формируется привязанность невелик, но вероятно, он вырастет со временем, к тому же такие люди являются самыми активными пользователями чат-ботов.

Другие исследования показывают, что стремительно растет процент тех, кто слишком полагается на ИИ не то только в общении, но и в вопросах работы или обучения. В итоге у людей постепенно снижаются навыки мышлений, обучения, запоминания, обмена информацией (социального общения). Исследователи указывают на то, что постоянное использование чат-ботов, вроде ChatGPT, Google Gemini и других подобных систем может привести к атрофия критического мышления и способностей самостоятельного рассуждения. Развивается поверхностное восприятие информации и снижается способность самовыражения. Иными словами, люди все чаще пытаются заставить «машину» думать и учиться вместо себя, вместо того, чтобы использовать ИИ только в роли помощника.

В краткосрочной перспективе, такой подход, возможно, дает положительный результат, но в дальнейшем может привести к эффекту т.н. «петли деградации» (Feedback loop in the degradation process) в которую попадут как люди, так и открытые системы искусственного интеллекта. Дело в том, что современные большие языковые модели, такие как ChatGPT, обучаются на текстах и других данных, созданных людьми: книгах, статьях, постах, комментариях, запросах, ответах. Если качество этих данных ухудшается (например, становится поверхностным или ошибочным), то и на выходе качество ответов ИИ будет снижаться.

На практике «петля деградации» выглядит примерно так. Люди начинают все больше полагаться на ИИ, чтобы избегать размышлений, упрощать тексты, получать быстрые и четкие ответы. В результате упрощается стиль общения, теряются нюансы, контекст, множатся штампы и шаблоны. ИИ снова обучается на этих данных, будущие версии модели будут тренироваться на упрощённых, однотипных и шаблонных данных. Получается порочный круг: глупеющий пользователь → упрощающийся ИИ → ещё более глупеющий пользователь и так далее.

Есть ли выход? Пока что да.

Разорвать порочный круг

Разорвать «петлю упрощения» можно, если снова поставить самостоятельное мышление и творчество в центр своей повседневной деятельности. Это означает не просто использовать ИИ как инструмент, а сознательно проверять его ответы, дополнять их, спорить с ними, а главное — думать самостоятельно, даже когда можно легко получить готовый результат. Мы должны вернуть себе роль активного участника, а не пассивного потребителя.

Один из ключевых шагов — восстановление глубины: в чтении, письме, диалоге, принятии решений. Это не значит отказываться от ИИ, но значит замедляться, когда нужно, и выделять время для собственного анализа и обдумывания. Такое интеллектуальное напряжение — это и есть форма активного сопротивления упрощению и деградации. Важно также воспитывать культуру, в которой качество важнее скорости. Потому что если ИИ учится у нас, то мы должны быть теми, у кого стоит учиться.