Штучний інтелект: велика можливість чи велика загроза?

2025-05-08

Відповідь на це питання стає все менш очевидною і хоча час для вибору правильного спрямування розвитку ще є, він швидко скорочується. При цьому головну загрозу несуть не технології, а як це найчастіше буває, людський фактор.

Чи потрібний новий «Манхеттенський проєкт»?

Приводом для роздумів стала велика стаття, яку опублікував колишній керівник Google Ерік Шмідт у співавторстві з Олександром Вангом, засновником Scale AI та Деном Хендріксом, директором Центру безпеки ШІ. У матеріалі Superintelligence Strategy («Стратегія надрозуму») який є у відкритому доступі, експерти міркують про те, що штучний інтелект, окрім явних переваг та загроз, може нести й приховані ризики. Насамперед, якщо ми говоримо про розвиток технологій на державному рівні — чого сьогодні прагнуть багато країн. Нагадаємо, що Ерік Шмідт обіймав вищі посади в Google та Alphabet Inc. з 2001 по 2017 роки, а потім ще якийсь час залишався там же в ролі технічного консультанта. З 2025 року Шмідт є генеральним директором Relativity Space, компанії з виробництва аерокосмічної техніки.

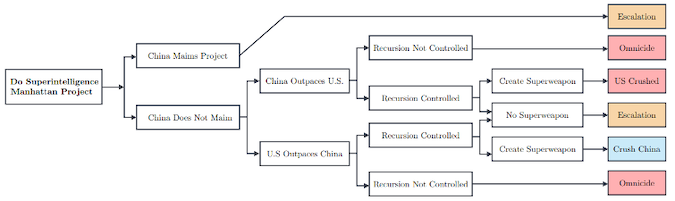

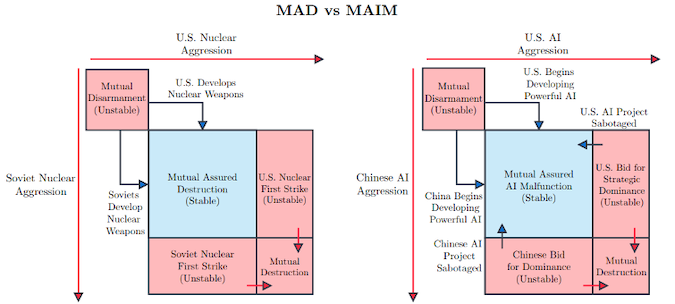

Це людина, яка володіє глибокими знаннями та досвідом у галузі ІТ і вважає, що стрімкий розвиток технологій ШІ, який ми спостерігаємо сьогодні, може призвести до неконтрольованої «перегони озброєнь», яка в результаті дорого обійдеться всім нам. Розмірковуючи про роль AI, експерт порівнює його значення з розробкою технологій розщеплення атомного ядра, які поряд із величезними перевагами дали світові ще й найнебезпечнішу зброю в історії. За словами Шмідта, США сьогодні стоїть на порозі створення чергового «Манхеттенського проєкту», цього разу в галузі штучного інтелекту, який може забезпечити країні безумовне глобальне домінування у цій сфері. Однак такі спроби, продовжує Шмідт, спровокують інші країни, насамперед Китай, на власні аналогічні програми, а головне на кібератаки та саботаж американських технологій.

Автори статті навіть запроваджують термін Mutual Assured AI Malfunction, MAIM (гарантоване взаємне неспрацювання ШІ), за аналогією з Mutual Assured Destruction (доктрина гарантованого взаємного знищення). MAIM означає, що найбільш небезпечні проєкти в галузі штучного інтелекту можуть бути виведені з ладу супротивником у вирішальний момент, причому такі можливості мають як США, так й Китай. Обидві держави все ще сильно залежать в галузі AI-технологій від ланцюжків постачання з інших країн та прихований саботаж можливий на різних етапах.

Уникнути ескалації, на думку експертів, допоможе розробка механізмів контролю над ланцюжками постачання у сфері ШІ, зокрема, пропонується налагодити контроль над прискорювачами обчислень (GPU/TPU) з такою ж строгістю та відповідальністю, як й у разі небезпечних хімічних чи радіоактивних матеріалів.

Іншим можливим шляхом зниження напруги може стати відмова від доктрини безумовного домінування, а також міжнародний контроль за розробкою ШІ-технологій. Всі ці рекомендації носять, звичайно, умоглядний характер, але привід з якого вон даються цілком відчутний, тому що технології штучного інтелекту все більше впливають не тільки на повсякденне життя, а й на баланс сил на міжнародній арені. Тому питання контролю тут може стати дуже гостро вже найближчим часом й на той момент добре було б мати готову відповідь на це питання.

Пастка «петлі деградації»

Вплив ШІ на міжнародні відносини та домінування країн — це високі матерії, нам набагато важливіше те, як штучний інтелект впливає на кожного прямо зараз. А вплив є і воно зростає. Нещодавнє масштабне дослідження, яке провели MIT Media Lab та OpenAI показало, що люди схильні до формування емоційної прихильності до чат-боту, який все частіше сприймається як справжній співрозмовник. У дослідженні, яке охопило тисячу чоловік і тривало близько місяця, розглядалися прояви т.зв. «афективного використання» — випадків, коли користувачі виявляють емпатію чи шукають підтримки у штучного інтелекту, як це був живий співрозмовник. Відсоток людей, у яких формується прихильність невеликий, але ймовірно, він зросте з часом, до того ж такі люди є найактивнішими користувачами чат-ботів.

Інші дослідження показують, що стрімко зростає відсоток тих, хто надто покладається на ШІ не лише у спілкуванні, але й у питаннях роботи або навчання. У результаті люди поступово втрачають навички мислення, навчання, запам'ятовування, обміну інформацією (соціального спілкування). Дослідники вказують на те, що постійне використання чат-ботів, на кшталт ChatGPT, Google Gemini та інших подібних систем, може призвести до атрофії критичного мислення та здібностей самостійного міркування. Розвивається поверхневе сприйняття інформації та знижується здатність самовираження. Іншими словами, люди все частіше намагаються змусити «машину» думати та вчитися за себе, замість того, щоб використати ШІ у ролі помічника.

У короткостроковій перспективі такий підхід, можливо, дає позитивний результат, але надалі може призвести до ефекту т.зв. «петлі деградації» (Feedback loop in the degradation process) в яку потраплять як люди, так й відкриті системи штучного інтелекту. Річ у тім, що сучасні великі мовні моделі, такі як ChatGPT, навчаються на текстах та інших даних, створених людьми: книгах, статтях, постах, коментарях, запитах, відповідях. Якщо якість цих даних погіршується (наприклад, стає поверхневою або помилковою), то й на виході якість відповідей ШІ буде знижуватися.

Насправді «петля деградації» виглядає приблизно так. Люди починають все більше покладатися на ШІ, щоб уникати роздумів, спрощувати тексти, отримувати швидкі та чіткі відповіді. В результаті спрощується стиль спілкування, губляться нюанси, контекст, множаться штампи та шаблони. ШІ знову навчається на цих даних, майбутні версії моделі тренуватимуться на спрощених, однотипних та шаблонних даних. Виходить порочне коло: спрощені дані та запити на вході → спрощення ШІ → ще спрощені дані та запити й так далі.

Чи є вихід? Поки що так.

Розірвати порочне коло

Розірвати «петлю спрощення» можна, якщо знову поставити самостійне мислення та творчість у центр своєї повсякденної діяльності. Це означає не просто використовувати ІШ як інструмент, а свідомо перевіряти його відповіді, доповнювати їх, сперечатися з ними, а головне — думати самостійно, навіть коли можна легко отримати готовий результат. Ми маємо повернути собі роль активного учасника, а не пасивного споживача.

Один із ключових кроків — відновлення глибини: читання, письма, діалогу, прийняття рішень. Це не означає відмовлятися від ШІ, але означає сповільнюватися, коли потрібно, та виділяти час для власного аналізу та обмірковування. Така інтелектуальна напруга — це і є форма активного опору спрощенню та деградації. Важливо також виховувати культуру, в якій якість важливіша за швидкість. Тому що якщо ШІ навчається у нас, то ми маємо бути тими, у кого варто вчитися.