Всего на всех не хватит — рост спроса на AI-технологии превращается в проблему

2024-06-13

Прорыв в области AI, отмеченный в последние пару лет, вызвал тектонические сдвиги во всем ИТ-мире. Но, уже очевидно, что для обеспечения долгосрочного прогресса нам необходимо пересмотреть многие устоявшиеся подходы — экономические, технологические, организационные, причем на глобальном уровне. Готовы ли мы к этому?

Спрос на технологии искусственного интеллекта (AI) и машинного обучения (ML), который продолжает стремительно расти, похоже, застал врасплох не только многие ИТ-отрасли, но и глобальную экономику в целом. Многие коммерческие компании и государственные организации, обоснованно, видят в ИИ огромный потенциал развития, способный обеспечить дополнительные прибыли, безопасность, повышение продуктивности и вообще все то что принято называть конкурентными преимуществами. Но, есть один фундаментальный нюанс — прикладные технологии AI/ML это лишь вершина айсберга. Для нормальной работы и прогресса в глобальных масштабах им требуется сложнейшая обеспечивающая инфраструктура — дата-центры, вычислительное оборудование, достаточное количество энергии и многое-многое другое. Причем все инфраструктурные компоненты должны работать и развиваться синхронно и достаточно быстро, а вот с этим то как раз намечаются проблемы.

Потребленье возрастает — производство отстает

Первый аспект, который сегодня беспокоит экспертов отрасли — производственный. Удастся ли чипмейкерам выпустить достаточные объемы полупроводниковой продукции для AI/ML, чтобы полностью удовлетворить спрос всех желающих? Особенность ИИ-нагрузок сегодня такова, что преимущество получают процессоры с большим количеством относительно простых ядер, способные производить параллельную обработку огромного количества относительно простых математических операций, но как можно быстрее. Такие задачи лучше всего выполняют специализированные GPU-акселераторы с тензорными ядрами (Tensor Processing Unit, TPU). Это, например, такие ускорители, как NVIDIA H100 и H40S (которые в частности, доступны в облаке De Novo) и другие модели. Спрос на них уже сегодня существенно превышает предложение, особенно в рамках облачного доступа (GPU Cloud).

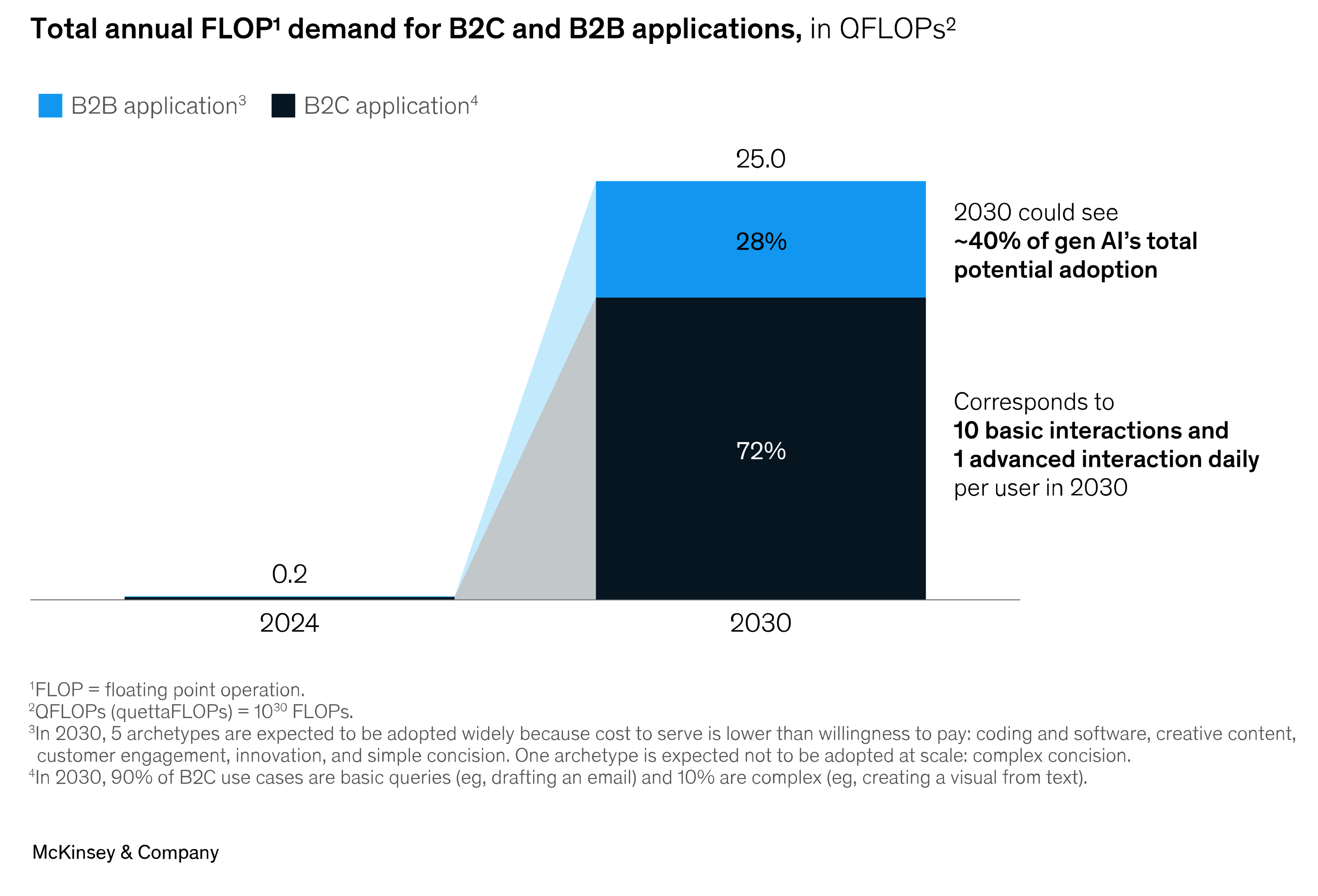

Аналитики консалтинговой компании McKinsey недавно подсчитали, что в 2024 году глобальные потребности вычислительной мощности только для задач AI/ML составят эквивалент 0,2×1030 FLOPs (floating point operations — операций с плавающей запятой), но уже к 2030 году этот показатель вырастет в 125 раз — до 25×1030 FLOPs.

При этом, 70% мощностей будет приходится на сегмент B2C и 30% на B2B. Во втором случае, наибольшим спросом будут пользоваться такие направления как:

- Решения для автоматизации разработки программного обеспечения

- Приложения для создания «обогащенного» контента — документов, специализированных презентаций и маркетинговых материалов

- Приложения для взаимодействия с клиентами, включая автоматизированное обслуживание, информационно-разъяснительную работу, сбор и обработку данных

- Решения для помощи в процессах процессов НИОКР

- Приложения, помогающие автоматизировать рутинные процессы, например создание разнообразной корпоративной отчетности, на основе массивов первичных структурированных данных.

- Системы, помогающие извлекать полезную информацию из огромными массивов неструктурированных данных (например, клинических изображений, МРТ или КТ).

Можно, конечно, спорить о конкретных значениях вышеупомянутых прогнозов, но общая тенденция очевидна — быстрый взрывоподобный темп роста спроса продолжится и его необходимо удовлетворить. Но, как обстоят дела с фактическим производством?

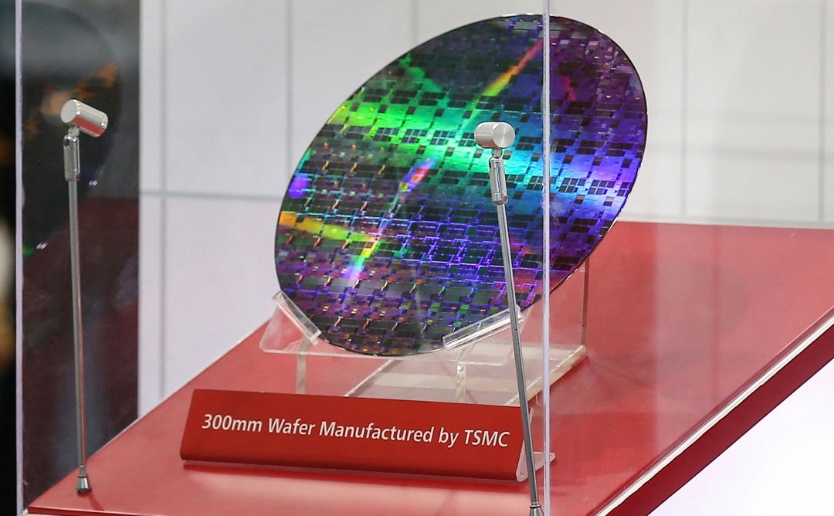

В начале нынешнего года, тайванская компания TSMC — мировой лидер в области полупроводникового производства — сообщила, что объем выпуска годных пластин (wafers), создаваемых по самому современному техпроцессу N3E, из которых затем делаются чипы, в ближайшее время будет увеличен с 60 до 100 тыс. в месяц. Возможности конкурирующих производителей, например, Samsung Electronics — на порядок меньше. Таким образом, по различным оценкам, в лучшем случае, суммарный мировой выпуск подходящих пластин в 2024 году составит около 1,3-1,35 млн и это при работе производителей с полной нагрузкой и без сбоев в цепочках поставок. О же время, у TSMC, как минимум 1 млн пластин уже выкуплены крупнейшими заказчиками — Apple, Intel, Qualcomm, NVIDIA и др.

Но, по расчетам McKinsey даже этого мало. Чтобы справится с растущими потребностями в мощностях, к 2030 году надо будет производить не менее 15 млн. пластин. И это только для процессоров, также, по данным аналитиков, 13-21 млн пластин понадобится для производства достаточного количества модулей быстрой оперативной памяти и еще некоторое количество — для SSD-накопителей и сетевых компонентов. Иными словами, производство должно увеличится в несколько десятков раз за ближайшие пять-шесть лет и для этого необходимо построить от 8 до 27 новых супертехнологичных фабрик, вложив десятки (или даже сотни) $ млрд. Если этого не сделать, то производство просто не успеет за спросом, что неминуемо приведет к сдерживанию прогресса в области искусственного интеллекта или, что скорее всего, современные технологии AI/ML станут доступны лишь узкому кругу самых богатых компаний, которые будут выкупать всю лучшую продукцию, невзирая на высокие цены. Так что глобальное развитие современной полупроводниковой отрасли сегодня остро стоит на повестке дня, в том числе и в контексте обеспечения «цифрового равенства».

Борьба за энергию

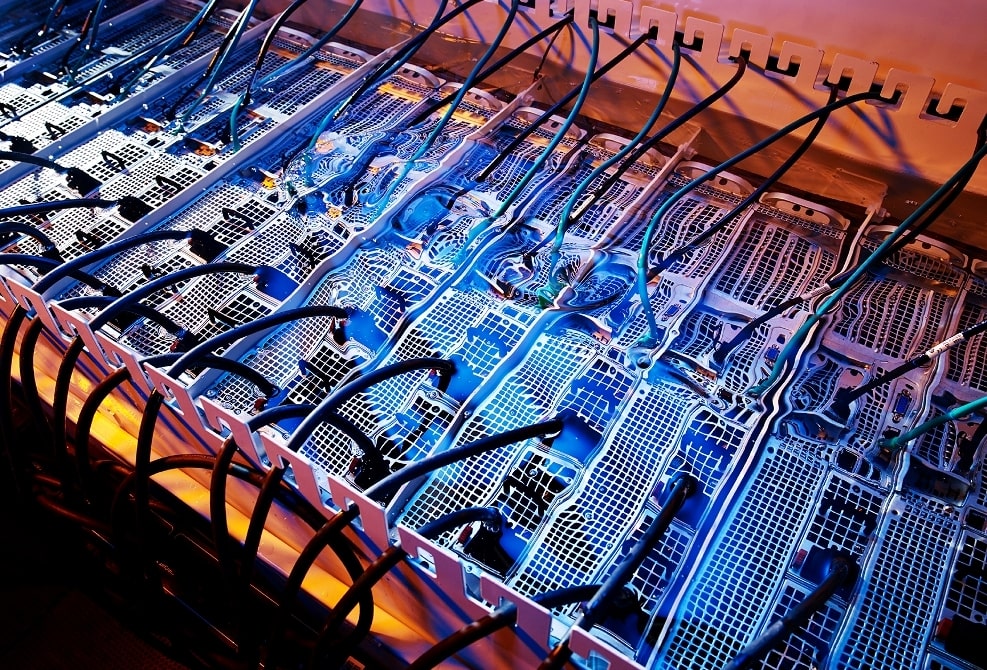

Помимо производственных сложностей, которые в будущем, потенциально, способны затормозить прогресс в области ИИ, есть еще и инфраструктурные. Серверы для AI/ML-задач требуют гораздо больше электрической мощности, чем традиционные системы. К примеру, комплексное решение NVIDIA DGX H100, в составе которого восемь TPU-акселераторов H100, занимая 6U в серверном шкафу может на пике нагрузки потреблять свыше 10 кВт электрической мощности. Теоретически, в один стандартный шкаф, в зависимости от его полезной емкости (например, 42U или 48U), можно установить 7-8 таких систем, что в сумме даст 70-80 кВт. К тому же вычислительное оборудование надо не только обеспечить электропитанием, но и отвести от него тепло.

При этом большинство дата-центров, работающий на сегодняшний день в мире, проектировалось с тем расчетом, что энергопотребление средней серверной стойки не превысит 5-6 кВт. Многие компании закладывали также возможность использования некоторого количества стоек «повышенной мощности» — на 10-15 кВт (иногда даже на несколько десятков кВт), но и этого вскоре может оказаться недостаточно. Крупнейшие операторы дата-центров, первыми обратили внимание на эту проблему и предложили пути решения. В конце прошлого года, крупнейший мировой оператор ЦОД, компания Equinix сообщила о доступности в своих дата-центрах стоек, оснащенных системой жидкостного охлаждения (СЖО). Такие решения, способные отводить от оборудования десятки кВт тепла, ранее были характерны только для суперкомпьютеров, теперь же они предлагаются в качестве стандартной опции для заказчиков, планирующих использовать оборудование для задач ИИ. Всего планируется оснастить СЖО более сотни площадок оператора по всему миру.

Основной конкурент Equinix — компания Digital Realty, также решила не отставать. В мае 2024 года колокейшн-провайдер сообщил о доступности в своих 170 дата-центрах стоек мощностью до 150 кВт (в перспективе обещают еще больше), оснащенных СЖО. Скорее всего, другие крупные игроки на рынке тоже поддержат данный тренд, ведь, по прогнозам аналитиков, в ближайшие несколько лет появятся заказчики, которым будут необходимы серверные стойки экстремальной мощности — 250 или даже 300 кВт — для AI/ML-задач. С такими нагрузками может справиться только СЖО, или иммерсионное охлаждение (в этом случае серверы целиком погружаются в специальный резервуар с диэлектрической жидкостью).

Быстрый рост вычислительной мощности, который отмечается в глобальных масштабах, ведет к увеличению общего энергопотребления дата-центров, как следствие, в ближайшей перспективе обозначилась проблема нехватки электричества. Например, по оценкам Марка Ганзи, руководителя DigitalBridge — еще одного крупнейшего мирового игрока в сегменте ЦОД и колокейшн — доступной сегодня электрической мощности хватит примерно на полтора-два года при нынешних темпах развития рынка коммерческих дата-центров. Топ-менеджер подчеркнул, что по состоянию на май 2024 года, в общей сложности, доступно 7 ГВт свободных электрических мощностей в США и 3 ГВт в ЕС. Речь идет не о суммарном потенциале генерации стран, а именно о той ее части, которая может быть использована дата-центрами. В целом, конечно, свободных мощностей гораздо больше, но подключить их к крупным ЦОДам либо невозможно либо невыгодно. В частности, Марк Ганзи отметил, что основные проблемы касаются не столько выработки электроэнергии, сколько ее распределения и доставки до объектов, поскольку имеющаяся ёмкость электросетей ограничена.

Всю эту ситуацию очень хорошо понимают крупные игроки ИТ-отрасли, поэтому многие компании наперегонки бронируют еще не введенные в строй мощности коммерческих дата-центров. Особенно заметна эта тенденция на самых развитых рынках. Так, по состоянию на первый квартал нынешнего года в США свободной емкости в коммерческих ЦОДах оставалось около 3,5% от общей емкости, а в тех площадках, которые еще только строятся было забронировано почти 85% мощности (свыше 2,5 ГВт). В ЕС и на азиатских рынках ситуация полегче, но, очевидно, дефицит мощностей скоро скажется и там. На фоне ажиотажного спроса растет цена аренды дата-центров — на 15-20% ежегодно, но это не останавливает заказчиков.

Возможно, дело в том, что по по оценкам S&P Market Intelligence, внедрение AI/ML-технологий обеспечивает в среднем увеличение годовой выручки компании на 58%. Если дело обстоит именно так, то это многое объясняет. В глобальном плане, не совсем понятно, что делать дальше — свободные емкости и мощности коммерческих дата-центров заканчиваются быстрее, чем объекты успевают ввести в эксплуатацию. Спрос обгоняет предложение и даже если сейчас компании решат вкладывать десятки миллиардов в создание новых площадок, на их строительство потребуется временя. Да и, снова-таки, непонятно — где брать дополнительную электрическую мощность, которой потребуется очень много. По различным оценкам, чтобы полностью удовлетворить спрос только на задачи, связанные с искусственным интеллектом, в ближайшие годы в мире потребуется не менее 38-40 ГВт дополнительной электрической мощности — в 3-4 раза больше, чем доступно сейчас. Но, очевидно, ее не будет в таких объемах — значит, часть будущих AI/ML-проектов реализовать не удастся, а конкуренция за ресурсы будет и дальше возрастать.

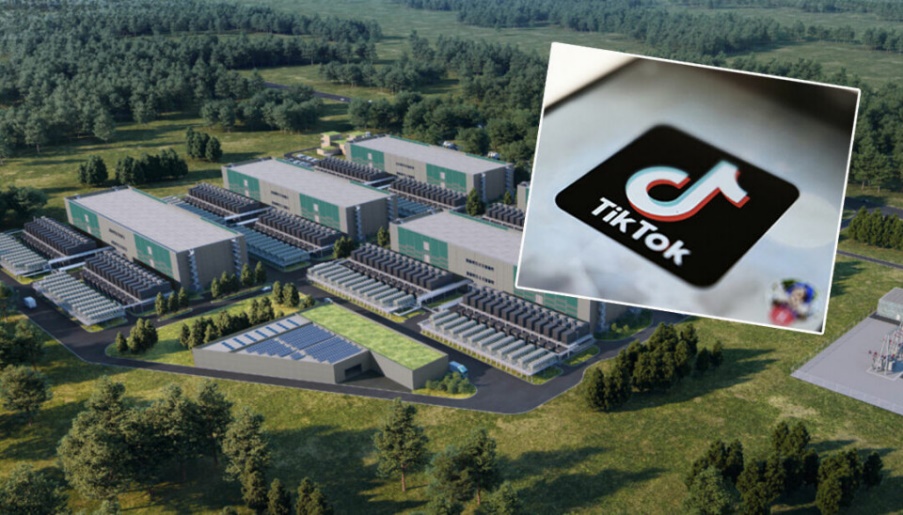

При этом, растущий спрос на энергию уже приводит к весьма неприятным ситуациям, как, например, недавно в Норвегии, где новый кампус дата-центров TikTok назвали чуть ли не угрозой национальной безопасности. Дело в том, что компания Green Mountain — крупный оператор коммерческих ЦОД —забронировала для нового европейского ЦОДа TikTok, который строится по соседству с норвежским городом Рауфосса, около 150 МВт, практически исчерпав доступные в данной местности электрические мощности. Все бы ничего, но в том же городе размешены заводы крупного европейского оборонного концерна Nammo (выпускает современные боеприпасы, ракетные двигатели, космическое оборудование и т.д.), который теперь очень ограничен в плане возможностей наращивания здесь своего производства, поскольку новые заводы попросту нечем будет питать. Вопрос сейчас пытаются решить и, скорее всего, компромисс будет найден, но сама ситуация показательна.

В общем, на пути развития AI/ML замаячили реальные сложности и если их не удастся разрешить в ближайшие годы, это может привести к замедлению темпов роста, как сегмента ИИ-технологий, в частности, так и мирового рынка ИТ в целом. Обнадеживает здесь тот факт, что все ключевые игроки понимают данные перспективы и усиленно работают над поиском приемлемых решений (без сомнения, привлекая для этого ресурсы искусственного интеллекта ). Так что, верим — ответы будут найдены и прогресс не остановится в ближайшие годы. В конце концов — это же в наших общих интересах.

Но, пока, доступные мощности для AI/ML еще есть, по крайней мере, в Украине — у нас. Сегодня компания De Novo предлагает доступ к мощнейшим TPU NVIDIA H100 и L40S непосредственно из окружения Kubernetes в составе новых облачных уcлуг Tensor Cloud (в коллективном облаке) и HTI (сервис класса GPU Private Cloud). А с PaaS-платформой ML Cloud вы получаете еще и готовую полноценную рабочую среду для ML-инженера (класса AWS SageMaker или Google Vertex AI).

Хотите узнать больше— обращайтесь за консультацией к нашим экспертам, которые не только ответят на ваши вопросы, но и помогут развернуть пилотный проект или перенести ИТ-нагрузки в облако De Novo.