На всіх не вистачить? Або чому зростання попиту на AI стає проблемою

2024-06-13

Швидкий прогрес в галузі технологій штучного інтелекту викликав тектонічні зрушення по всьому ІТ-світі. Проте вже зрозуміло, що для забезпечення довгострокового сталого розвитку треба переглянути багато усталених підходів — економічних, технологічних, організаційних, причому на глобальному рівні. Чи готові ми до цього?

Попит на технології штучного інтелекту (AI) та машинного навчання (ML), що продовжує стрімко зростати, схоже, застав зненацька не лише більшість ІТ-галузей, але й глобальну економіку в цілому. Комерційні компанії та державні організації, обґрунтовано, бачать у ШІ величезний потенціал розвитку, здатний забезпечити додаткові прибутки, безпеку, підвищення продуктивності й взагалі все те, що називають конкурентними перевагами. Але є один фундаментальний нюанс — прикладні технології AI/ML це лише вершина айсберга. Для нормальної роботи та забезпечення прогресу в глобальних масштабах їм потрібна дуже складна підтримуюча інфраструктура — дата-центри, обчислювальне обладнання, достатня кількість енергії та багато чого іншого. До того ж всі інфраструктурні компоненти повинні працювати та розвиватися синхронно й досить швидко, а з цим можуть бути певні проблеми.

Споживання зростає — виробництво відстає

Перший аспект, який сьогодні непокоїть експертів галузі — виробничий. Чи вдасться чипмейкерам випускати достатні обсяги напівпровідникової продукції для галузі AI/ML, щоб повністю задовольнити попит усіх охочих? Особливість ШІ-навантажень сьогодні така, що перевагу отримують процесори з великою кількістю простих ядер, здатні здійснювати паралельну обробку величезної кількості відносно простих математичних операцій. З такими задачами якнайкраще можуть впоратися спеціалізовані GPU-акселератори з тензорними ядрами (Tensor Processing Unit, TPU). Це, наприклад, такі прискорювачі, як NVIDIA H100 та H40S (що, зокрема, доступні у хмарі De Novo) та інші моделі. Попит на них вже сьогодні значно перевищує пропозицію, особливо в рамках послуг хмарного доступу (GPU Cloud).

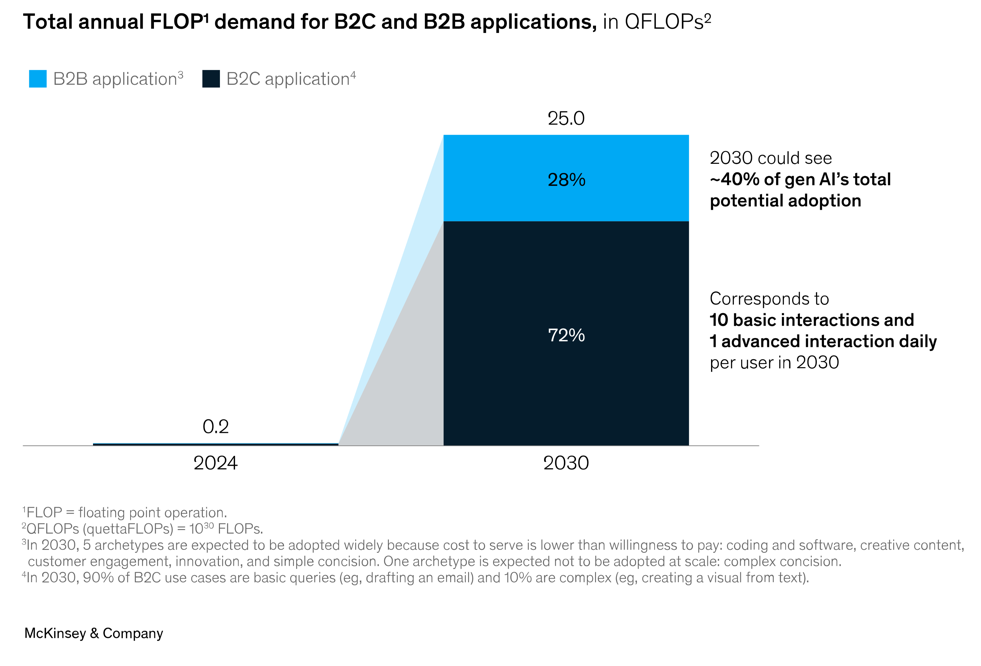

Аналітики консалтингової компанії McKinsey нещодавно підрахували, що у 2024 році глобальні потреби обчислювальної потужності лише для завдань AI/ML складуть еквівалент 0,2×1030 FLOPs (floating point operations — операції з плаваючою комою), але вже до 2030 року цей показник зросте у 125 разів — до 25×030 FLOPs.

При цьому 70% потужностей буде припадати на сегмент B2C і 30% на B2B. У останньому випадку найбільшим попитом будуть користуватися такі напрямки як:

- Рішення для автоматизації розробки програмного забезпечення

- ПЗ для створення «збагаченого» контенту — документів, спеціалізованих презентацій, маркетингових матеріалів

- Програми для взаємодії з клієнтами, включаючи автоматизоване обслуговування, інформаційно-роз'яснювальну роботу, збирання та обробку даних

- Рішення для допомоги в процесах, пов’язаних з науково-дослідними та дослідно-конструкторськими роботами (НДДКР)

- Програми, що допомагають автоматизувати рутинні процеси, наприклад створення різноманітної корпоративної звітності, на основі масивів первинних структурованих даних.

- Системи, що допомагають отримати корисну інформацію з величезних масивів неструктурованих даних (наприклад, клінічних зображень, МРТ або КТ).

Можна, звичайно, сперечатися про конкретні значення вищезгаданих прогнозів, але загальна тенденція очевидна — швидкий вибухоподібний темп зростання попиту продовжиться і його необхідно задовольнити. Але, чи впораються з ним виробники?

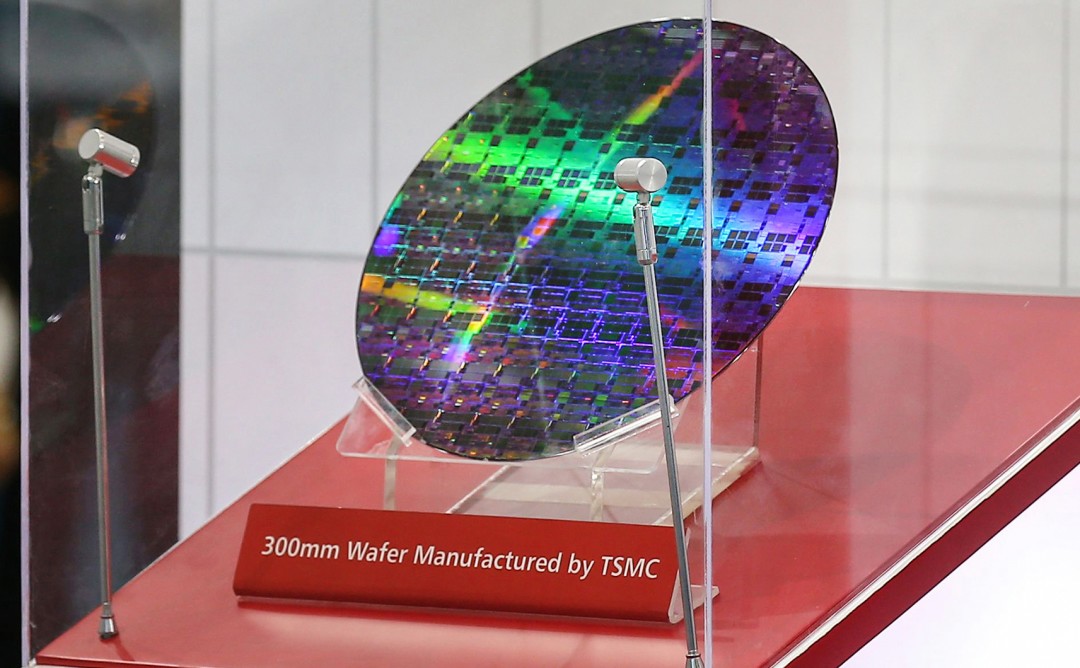

На початку цього року тайванська компанія TSMC — світовий лідер у галузі напівпровідникового виробництва повідомила, що обсяг випуску придатних пластин (wafers), що виготовляються за найсучаснішим техпроцесом N3E, з яких потім робляться чіпи, найближчим часом буде збільшено з 60 до 100 тис. на місяць. Можливості конкуруючих виробників, наприклад, Samsung Electronics — в багато разів менші. Тобто загалом, як свідчать оцінки експертів, у кращому випадку, сумарний випуск відповідних пластин у 2024 році складе близько 1,3-1,35 млн й це з умов роботи виробників з повним навантаженням та без збоїв у поставках. О й же час, лише у TSMC як мінімум 1 млн пластин уже викуплено найбільшими замовниками — Apple, Intel, Qualcomm, NVIDIA та ін.

Але, за розрахунками McKinsey, навіть цього замало. Щоб задовольнити потреби, обсяги виробництва треба швидко збільшувати, бо у 2030 році треба буде виготовляти не менше 15 млн пластин. Й це лише для процесорів, також, за даними аналітиків, 13-21 млн пластин знадобиться для виробництва достатньої кількості модулів швидкої оперативної пам'яті та ще кілька мільонів — для SSD-накопичувачів і мережевих компонентів. Іншими словами, виробництво має збільшитись в кілька десятків разів у найближчі п'ять-шість років й для цього необхідно буде побудувати від 8 до 27 нових супертехнологічних фабрик, вклавши десятки (або навіть сотні) $ млрд. Якщо цього не зробити, то виробництво просто не встигне за попитом, що неминуче призведе до стримування прогресу в галузі штучного інтелекту або, що швидше за все, сучасні технології AI/ML стануть доступними лише вузькому колу найбагатших компаній, які викуповуватимуть всю найкращу продукцію, навіть попри високі ціни. Тож глобальний розвиток сучасної напівпровідникової галузі сьогодні гостро стоїть на порядку денному, зокрема й у контексті забезпечення «цифрової рівності».

Боротьба за енергію

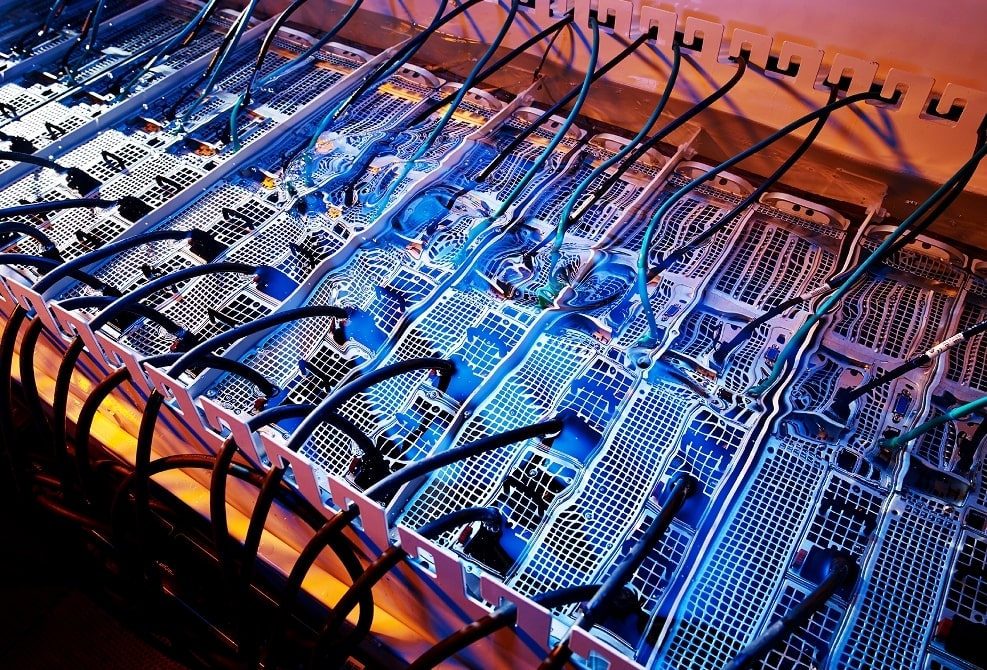

Крім виробничих складнощів, які у майбутньому потенційно здатні загальмувати прогрес у галузі ШІ, є ще й інфраструктурні. Сервери для AI/ML вимагають набагато більше електричної потужності, ніж традиційні системи. Наприклад, комплексне рішення NVIDIA DGX H100, у складі якого є вісім TPU-акселераторів H100, займаючи 6U в серверній шафі, може на максимумі навантаження споживати понад 10 кВт електричної потужності. Теоретично, в одну стандартну шафу, залежно від її корисної місткості (наприклад, 42U або 48U), можна встановити 7-8 таких систем, що в сумі дасть 70-80 кВт. До того ж обчислювальне обладнання треба не лише забезпечити електроживленням, а й відвести від нього тепло.

Той же час більшість дата-центрів, які працюють на сьогодні у світі, проєктувалися з тим розрахунком, що енергоспоживання середньої серверної стійки не перевищить 5-6 кВт. Багато компаній закладали також можливість використання певної кількості стійок «підвищеної потужності» — на 10-15 кВт (іноді навіть на кілька десятків кВт), але незабаром навіть цього може виявитися недостатньо. Найбільші оператори дата-центрів першими звернули увагу на цю проблему та запропонували шляхи вирішення.

Наприкінці минулого року, найбільший світовий оператор ЦОД, компанія Equinix повідомила про доступність у своїх дата-центрах потужних стійок, оснащених системою рідинного охолодження (СРО). Такі рішення, що здатні відводити від обладнання десятки кВт тепла, раніше були характерні лише для суперкомп'ютерів, тепер вони пропонуються як стандартна опція для замовників, які планують використовувати обладнання для задач ШІ. Загалом планується оснастити СРО понад сотню майданчиків оператора по всьому світі.

Основний конкурент Equinix – компанія Digital Realty, також вирішила не відставати. У травні 2024 року колокейшн-провайдер повідомив про доступність у своїх 170 дата-центрах стійок потужністю до 150 кВт (у перспективі обіцяють ще більше), оснащених СРО. Швидше за все інші великі гравці на ринку теж підтримають тренд, адже, за прогнозами аналітиків, у найближчі кілька років з'являться замовники, яким будуть потрібні серверні стійки екстремальної потужності – 250 або навіть 300 кВт – для AI/ML-задач. З такими навантаженнями затне впоратись лише СРО, або навіть імерсійне охолодження (у цьому випадку сервери занурюються у спеціальний резервуар з діелектричною рідиною).

Швидке зростання обчислювальної потужності у глобальних масштабах, веде до збільшення загального енергоспоживання дата-центрів, як наслідок, у найближчій перспективі окреслилася проблема нестачі електрики. Наприклад, за оцінками Марка Ганзі, керівника DigitalBridge — ще одного найбільшого світового гравця в сегменті ЦОД та колокейшн — доступної сьогодні електричної потужності вистачить приблизно на півтора-два роки за нинішніх темпів розвитку ринку комерційних дата-центрів. Топменеджер підкреслив, що станом на травень 2024 року, загалом, доступно 7 ГВт вільних електричних потужностей у США та 3 ГВт у ЄС. Йдеться не про сумарний потенціал генерації країн, а саме про ту частину, яка може бути використана дата-центрами. Загалом, звичайно, вільних потужностей більше, але під'єднати їх до великих ЦОДів неможливо або невигідно. Зокрема, Марк Ганзі зазначив, що основні проблеми пов’язані не стільки з генерацією електроенергії, скільки з її розподілом та доставленням до об'єктів, бо наявна місткість електромереж обмежена.

Цю ситуацію дуже добре розуміють великі гравці ІТ-галузі, тому багато компаній наввипередки бронюють ще не введені в дію потужності комерційних дата-центрів. Особливо помітна ця тенденція на прикладі найрозвиненіших ринків. Наприклад, станом на перший квартал нинішнього року в США вільних резервів у всіх комерційних ЦОДах залишалося близько 3,5% від загальної місткості, а в тих майданчиках, які ще будуються, було заброньовано майже 85% потужності (еквівалент понад 2,5 ГВт). У ЄС та на азійських ринках ситуація трохи легша, але, очевидно, дефіцит потужностей незабаром позначиться й там. На тлі такого попиту зростає ціна оренди дата-центрів – на 15-20% щороку, але навіть це не зупиняє замовників.

Можливо, річ у тому, що за оцінками S&P Market Intelligence, використання AI/ML-технологій забезпечує в середньому збільшення річного виторгу компанії на 58%. Якщо дійсно так, то це багато що пояснює. У глобальному плані не зовсім зрозуміло, що робити далі — вільні місткості та потужності комерційних дата-центрів закінчуються швидше, ніж об'єкти встигають ввести в експлуатацію. Попит обганяє пропозицію й навіть якщо зараз компанії вирішать вкладати десятки мільярдів у створення нових майданчиків, на їхнє будівництво знадобиться час. Та й, знов-таки, незрозуміло — де брати додаткову електричну потужність, якої треба дуже багато. За різними оцінками, щоб повністю задовольнити попит лише на потужності, орієнтовані на задачі штучного інтелекта, найближчими роками у світі потрібно буде не менше 38-40 ГВт додаткової електричної потужності — у 3-4 рази більше, ніж є зараз. Але, схоже, що її не буде у таких обсягах — значить частину майбутніх AI/ML-проєктів реалізувати не вдасться, а конкуренція за ресурси зростатиме й надалі.

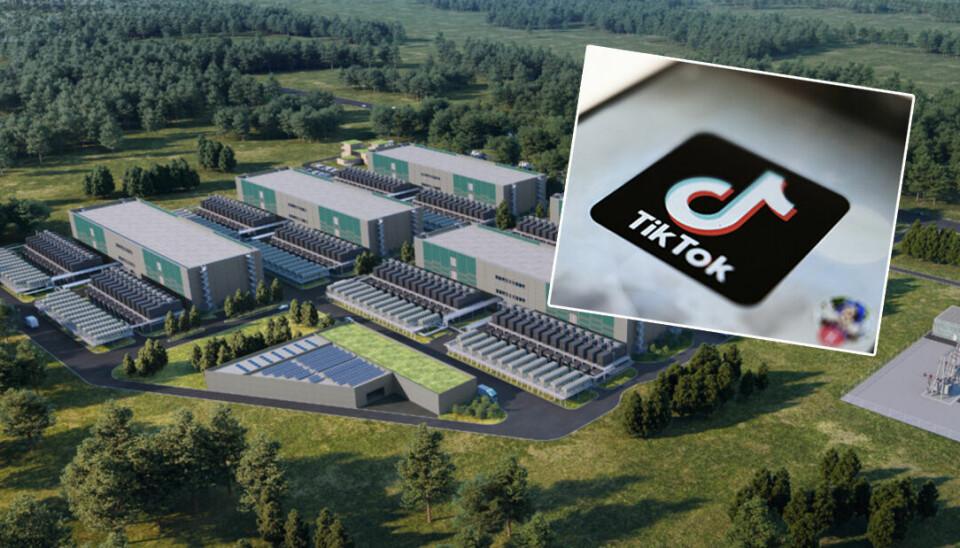

Попит на енергію вже призводить до вельми неприємних ситуацій, як, наприклад, нещодавно у Норвегії, де новий кампус дата-центрів TikTok може стати потенційною загрозою національній безпеці. Річ у тім, що компанія Green Mountain — великий оператор комерційних ЦОД — забронювала для нового європейського ЦОДа TikTok, який будується по сусідству з норвезьким містом Рауфосса, близько 150 МВт, практично вичерпавши доступні в цій місцевості електричні потужності. Все б нічого, але в тому самому місті розміщені заводи великого європейського оборонного концерну Nammo (випускає сучасні боєприпаси, ракетні двигуни, космічне обладнання тощо), що тепер дуже обмежений у плані можливостей нарощування тут свого виробництва, бо нові заводи просто не буде чим живити. Питання зараз намагаються вирішити та, найімовірніше, компроміс буде знайдено, але сама ситуація показова.

Отже, на шляху розвитку AI/ML вже можна побачити реальні складнощі, якщо їх не вдасться вирішити найближчими роками, це може призвести до уповільнення темпів зростання сегмента ШІ-технологій, та світового ринку ІТ в цілому. Проте надію дає той факт, що всі ключові гравці розуміють такі перспективи та посилено працюють над пошуком прийнятних рішень (без сумніву, залучаючи для цього ресурси штучного інтелекту ). Тож віримо — відповіді буде знайдено й прогрес не зупиниться найближчими роками. Зрештою, це ж у наших спільних інтересах.

Зазначмо, що доступні потужності для AI/ML-задач поки що є, принаймні в Україні. Сьогодні компанія De Novo пропонує доступ до найпотужніших TPU NVIDIA H100 та L40S безпосередньо з оточення Kubernetes у складі нових хмарних послуг Tensor Cloud (у колективній хмарі) та HTI (сервіс класу GPU Private Cloud), а з PaaS-платформою ML Cloud ви отримуєте ще й готове повноцінне робоче середовище для ML-інженера (класу AWS SageMaker або Google Vertex AI).

Бажаєте дізнатися більше — звертайтеся за консультацією до наших експертів, які не тільки нададуть відповідь на ваші запитання, але й допоможуть розгорнути пілотний проєкт або перенести ІТ-навантаження в хмару De Novo.