NVIDIA запускает Dynamo — обновленную программную платформу для LLM-кластеров

2025-05-06

Компания NVIDIA представила Dynamo — инновационную программную платформу нового поколения для ускорения и масштабирования инференса больших языковых моделей. Новый инструмент, пришедший на смену Triton Inference Server, предлагает разработчикам гибкие и мощные возможности для построения эффективных ИИ-фабрик, минимизируя издержки и повышая эффективность использования вычислительных ресурсов.

NVIDIA анонсировала новую открытую платформу Dynamo — преемника Triton Inference Server — для ускорения инференса и масштабирования ИИ-моделей в дата-центрах. Генеральный директор компании Дженсен Хуанг описал Dynamo как «операционную систему для ИИ-фабрик». Разработанная с упором на повышение производительности и снижение стоимости эксплуатации, платформа особенно эффективна при запуске сложных LLM-моделей.

Больше интеллекта и эффективности для LLM

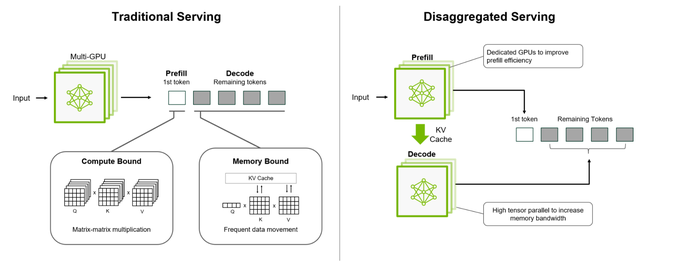

Платформа Dynamo оптимизирует распределение нагрузки на большое количество графических ускорителей (GPU/TPU), позволяя максимально использовать доступные ресурсы. Она поддерживает разделение обработки и генерации LLM-запросов по различным ускорителям — это так называемая дезагрегированная архитектура, которая позволяет тонко настраивать каждый этап инференса под его конкретные требования.

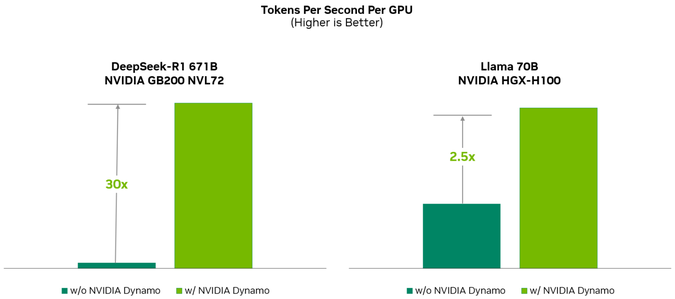

На примере модели Llama, запущенной на ускорителях c архитектурой Hopper (к ним относятся, в частности, модели серий H100 и H200), отмечается удвоение производительности без увеличения числа устройств. В случае DeepSeek-R1 на кластере GB200 NVL72 Dynamo позволила добиться прироста скорости генерации токенов более чем в 30 раз на каждый ускоритель.

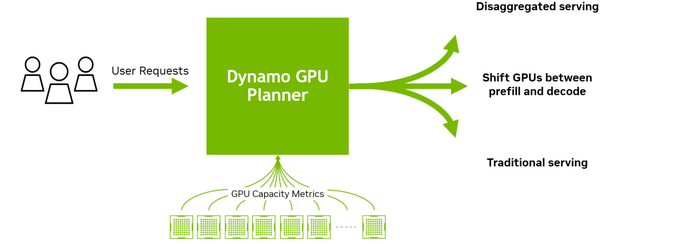

Одной из сильных сторон Dynamo является интеллектуальное управление ресурсами. Система может динамически перераспределять задачи, адаптируясь под текущую нагрузку, а также эффективно использовать доступную память и хранилища для кеширования и повторного доступа к данным инференса. Платформа с открытым исходным кодом совместима с такими инструментами, как PyTorch, SGLang, NVIDIA TensorRT-LLM и vLLM. Это открывает широкие возможности для интеграции и развертывание на самых разных облачных платформах.

Dynamo также внедряет механизм распределения KV-кеша между тысячами ускорителей. Новые запросы направляются туда, где уже имеются наиболее подходящие сохранённые данные, что снижает избыточные вычисления. Платформа использует дезагрегацию стадий обработки — от анализа до генерации — между разными ускорителями, что особенно полезно для «рассуждающих» ИИ-систем. Такой подход обеспечивает более высокую производительность и ускоряет отклик.

В числе основных компонентов NVIDIA Dynamo:

- GPU Planner — модуль адаптивного планирования количества задействованных ускорителей;

- Smart Router — интеллектуальный маршрутизатор, минимизирующий повторную обработку;

- Low-Latency Communication Library — библиотека для быстрой передачи данных между ускорителями;

- Memory Manager — «умный» менеджер памяти для эффективного хранения и извлечения данных.

В ближайшее время NVIDIA Dynamo будет доступна в составе микросервисов NVIDIA NIM и станет частью будущих релизов NVIDIA AI Enterprise. Благодаря гибкости и высокой производительности, платформа может стать популярным инструментом для построения масштабируемых и экономически эффективных решений в области инференса LLM-моделей.