NVIDIA запускає Dynamo — оновлену програмну платформу для LLM-кластерів

2025-05-06

Компанія NVIDIA представила Dynamo — інноваційну програмну платформу нового покоління для прискорення та масштабування інференсу великих мовних моделей (LLM). Новий інструмент, який приходить на зміну Triton Inference Server, пропонує розробникам гнучкі та потужні можливості для створення ефективних ШІ-фабрик, мінімізуючи витрати та підвищуючи ефективність використання обчислювальних ресурсів.

Нещодавно NVIDIA анонсувала нову відкриту платформу Dynamo — наступника Triton Inference Server — для прискорення інференсу та масштабування ШІ-моделей у дата-центрах. Генеральний директор компанії Дженсен Хуанг описав Dynamo як «операційну систему для ШІ-фабрик». Розроблена з акцентом на підвищення продуктивності та зниження вартості експлуатації, платформа особливо ефективна при запуску складних моделей LLM.

Більше інтелекту та ефективності для LLM

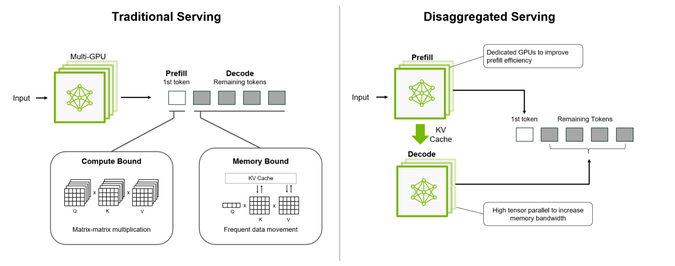

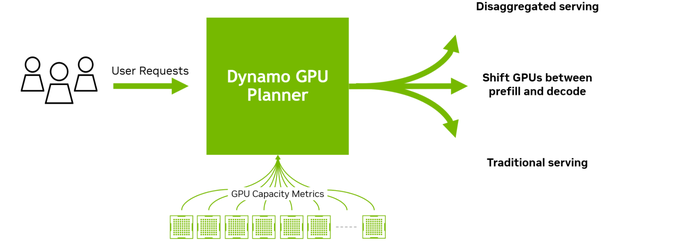

Платформа Dynamo оптимізує розподіл навантаження на велику кількість графічних прискорювачів (GPU/TPU), дозволяючи максимально використовувати доступні ресурси. Вона підтримує розділення обробки та генерації LLM-запитів між різними прискорювачами — так звана дезагрегована архітектура, яка дозволяє точно налаштовувати кожен етап інференсу відповідно до його конкретних вимог.

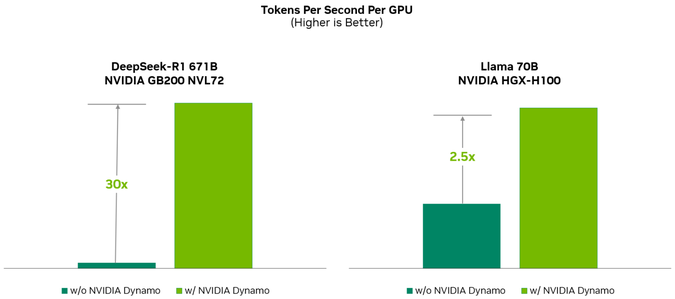

На прикладі моделі Llama, запущеної на прискорювачах з архітектурою Hopper (зокрема, серії H100 та H200), зафіксовано подвоєння продуктивності без збільшення кількості пристроїв. У випадку з DeepSeek-R1 на кластері GB200 NVL72 платформа Dynamo забезпечила збільшення швидкості генерації токенів більш ніж у 30 разів на кожен прискорювач.

Однією з сильних сторін Dynamo є інтелектуальне управління ресурсами. Система може динамічно перерозподіляти задачі відповідно до поточного навантаження, а також ефективно використовувати доступну пам’ять і сховища для кешування та повторного доступу до даних інференсу. Платформа з відкритим вихідним кодом сумісна з такими інструментами, як PyTorch, SGLang, NVIDIA TensorRT-LLM та vLLM. Це відкриває широкі можливості для інтеграції та розгортання на різних хмарних платформах.

Dynamo також впроваджує механізм розподілу KV-кешу між тисячами прискорювачів. Нові запити спрямовуються туди, де вже зберігаються найбільш релевантні дані, що знижує надлишкові обчислення. Платформа використовує дезагрегацію стадій обробки — від аналізу до генерації — між різними прискорювачами, що особливо корисно для ШІ-систем, які виконують складні логічні операції чи «міркування». Такий підхід забезпечує вищу продуктивність й прискорений відгук.

Основні компоненти NVIDIA Dynamo:

- GPU Planner — модуль адаптивного планування кількості задіяних прискорювачів;

- Smart Router — інтелектуальний маршрутизатор, який мінімізує повторну обробку;

- Low-Latency Communication Library — бібліотека для швидкої передачі даних між прискорювачами;

- Memory Manager — «розумний» менеджер пам’яті для ефективного зберігання та отримання даних.

Найближчим часом NVIDIA Dynamo стане доступною як частина мікросервісів NVIDIA NIM та увійде до майбутніх релізів NVIDIA AI Enterprise. Завдяки гнучкості та високій продуктивності, платформа може стати популярним інструментом для створення масштабованих та економічно ефективних рішень у сфері інференсу LLM-моделей.