Мережа, як ключовий елемент AI-інфраструктури. Підсумки Broadcom Investor Day

2024-04-18

Наприкінці березня 2024 року компанія Broadcom — до складу якої сьогодні входить також і VMware — провела найбільший щорічний захід для інвесторів, де презентувала своє бачення майбутнього в галузі AI.

Успіх технологій штучного інтелекту багато в чому залежить від продуктивної апаратної бази. Саме тому сьогодні спостерігається ажіотажний попит на всілякі акселератори і спеціалізовані AI/ML-процесори. Водночас різнорідна інфраструктура і складні кластери вимагають також високошвидкісних каналів зв'язку на всіх рівнях.

Навіть найкращі прискорювачі втрачають ефективність, якщо результати обчислень не можна передати на інші вузли з достатньою швидкістю. Саме цьому питанню було присвячено значну частину дискусії на щорічному форумі Broadcom Investor Day, який відбувся 20 березня в Сан-Хосе (Каліфорнія, США).

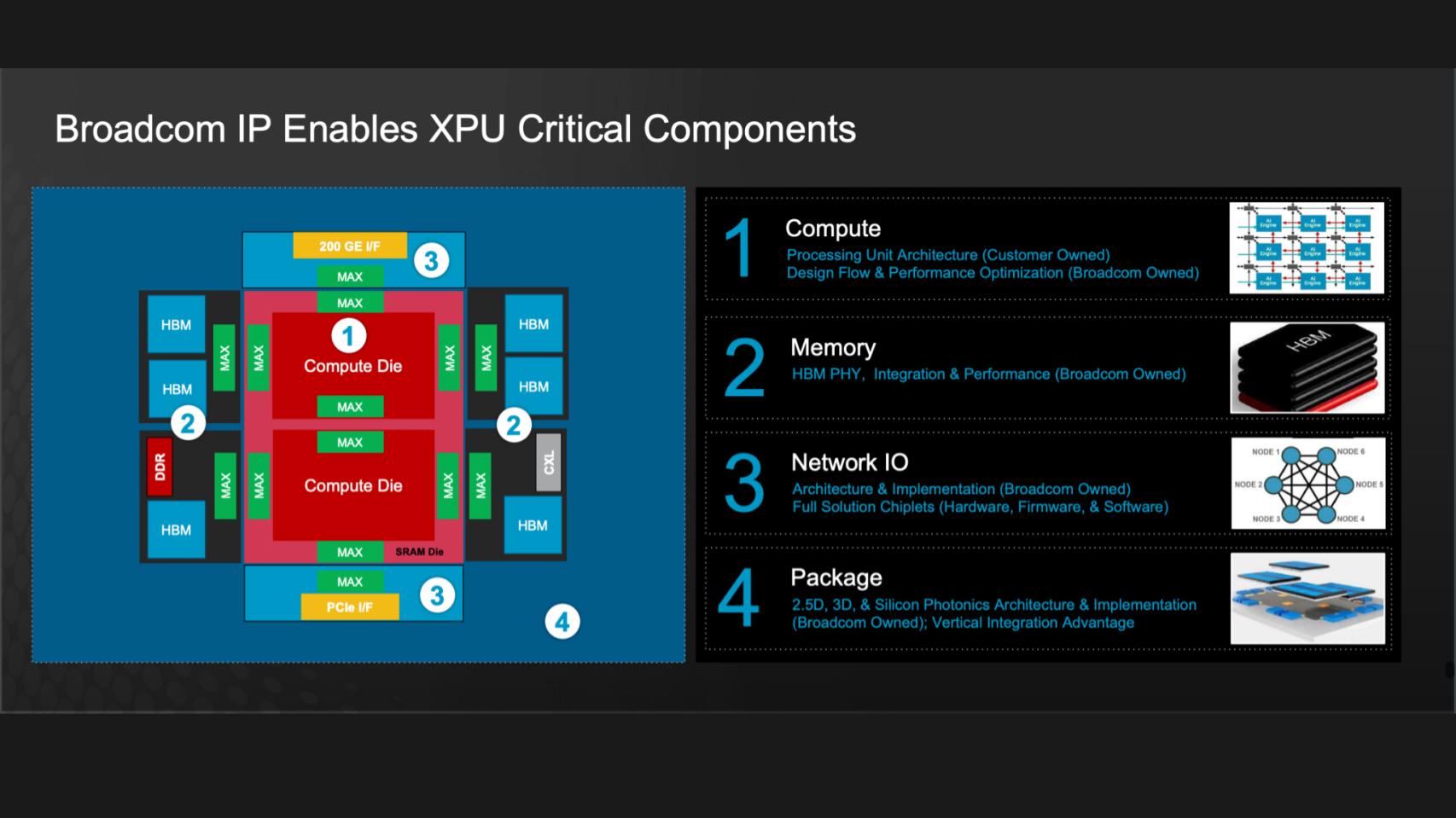

Спираючись на свій досвід і аналізуючи портфель замовлень компанії, експерти Broadcom транслювали ідею того, що на даному етапі розвитку ІТ-галузі, головний акцент зміщується з орієнтації на процесори до можливостей підключення і передачі даних. Так, якщо ще зовсім недавно ключову роль у процесі обчислень відігравали центральні процесори (CPU), то сьогодні, через швидкий розвиток AI/ML це завдання дедалі частіше делегують спеціалізованим чипам. У професійний ужиток уже міцно ввійшли такі поняття як GPU (Graphics processing unit), TPU (Tensor Processing Unit), NPU (Neural Processing Unit), LPU (Neuron Processing Unit), імовірно, невдовзі з'являться й інші. Усе те можна узагальнити терміном XPU. Зараз завдання полягає в тому, щоб забезпечити цим різнорідним процесорам достатній зв'язок у рамках єдиної системи.

Саме на цьому Broadcom робить акцент у майбутніх виробничих планах. Зокрема, компанія очікує, що за підсумками нинішнього року 35% її доходів буде отримано від продажу напівпровідникових рішень для систем, орієнтованих на AI. Сьогодні, нагадаємо, три найбільші клієнти Broadcom — це Google, Meta і NVIDIA (остання зростає швидше за всіх).

На форумі компанія також представила цілісну концепцію побудови інфраструктур для завдань штучного інтелекту і машинного навчання. У загальних рисах вона показана на малюнку нижче: праворуч — ключові компоненти, зліва — сфери, де вони застосовуються (позначені відповідними цифрами).

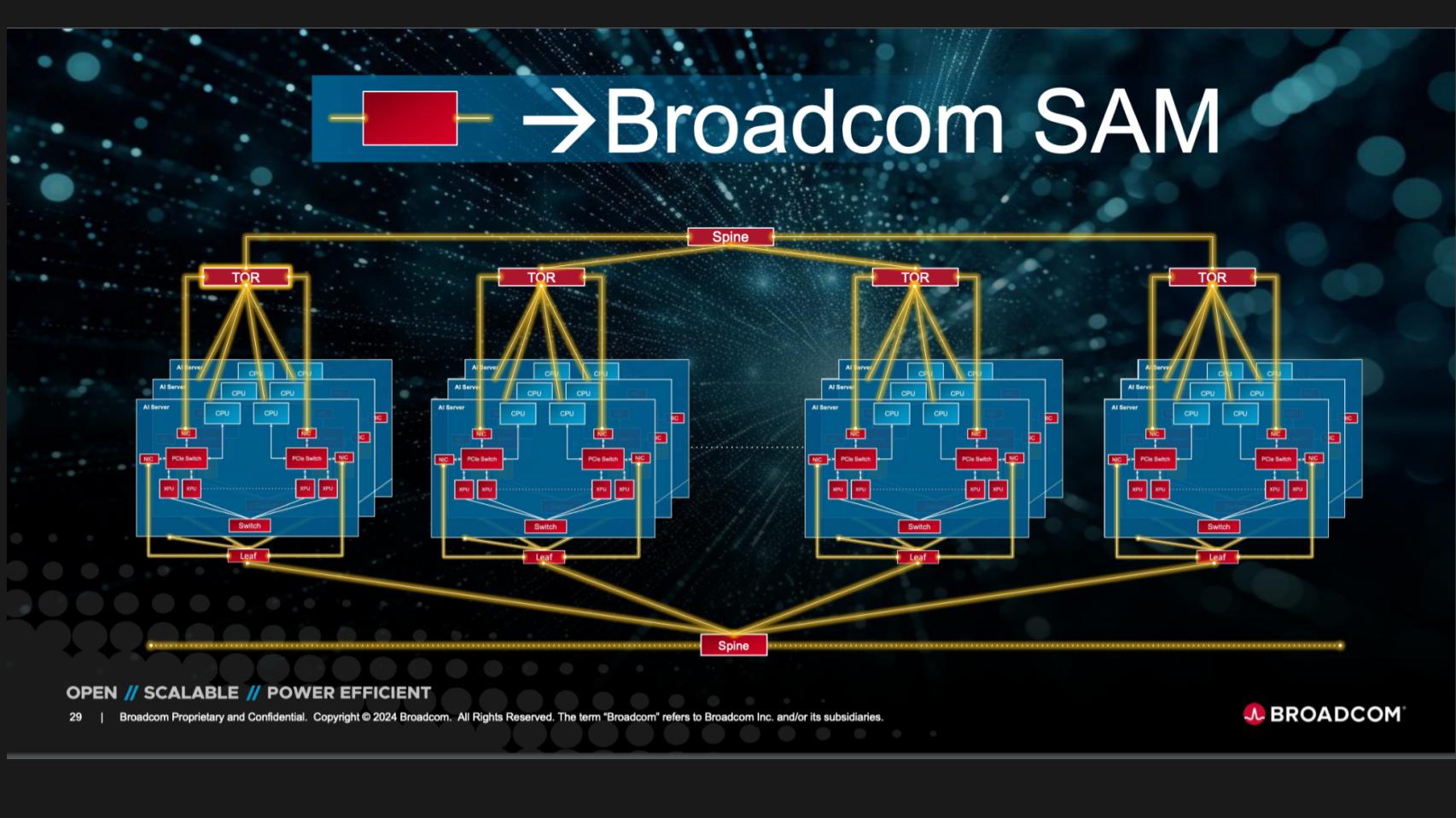

Також Broadcom показала концепцію об'єднання AI-кластерів, з послідовним й узгодженим з'єднанням усіх основних мережевих компонентів - від внутрішніх шин на кшталт PCIe до магістральних комутаторів.

Разом з тим відкритим залишилося ще одне важливе питання, що його жваво обговорювали на форумі — яка технологія інтерконекту має краще майбутнє. Наприклад, представники NVIDIA очікувано наводили аргументи на користь Infiniband (на основі якої компанія пропонує власну технологію NVLink), а експерти Broadcom вважають, що Ethernet теж має тут великі перспективи (наводячи як приклад вдалий досвід своїх клієнтів — Google і Meta — у сфері AI).

Загалом, мережа на всіх рівнях перестає бути вузьким місцем в інфраструктурі AI/ML, а отже, ми, без сумніву, побачимо нові прориви і досягнення у сфері штучного інтелекту вже цього року.

Нагадаємо, що сьогодні потужну надійну та продуктивну інфраструктуру для AI/ML на основі найновіших апаратних та програмних компонентів можна отримати у хмарі De Novo – у складі сервісів Tensor Cloud, HTI та ML Cloud. Звертайтеся за консультацією до наших експертів.