Як NVIDIA AI Enterprise змінює правила гри в AI та ML

2025-04-29

NVIDIA AI Enterprise — це корпоративна платформа для повного циклу роботи з AI/ML-навантаженнями. Вона поєднує оптимізовані бібліотеки, інструменти й сервіси, щоб забезпечити масштабованість, стабільність та підтримку. Давайте розглянемо архітектуру, функції та переваги платформи, а також покроковий підхід до впровадження.

Штучний інтелект стає критичним ресурсом у цифровій економіці. Компанії прагнуть впроваджувати рішення на базі штучного інтелекту для підвищення операційної ефективності, автоматизації процесів та отримання конкурентних переваг. Втілення AI-технологій, особливо у складних інфраструктурах, часто стикається з проблемами сумісності, безперервності та підтримки. Саме ці чинники стали точкою входу для NVIDIA AI Enterprise — інтегрованої платформи, що спрощує шлях до створення, розгортання та супроводження AI/машинного навчання (МL) рішень. Це сучасний інструмент для проектів будь-якої складності, від пілотних POC до масштабних впроваджень.

Огляд NVIDIA AI Enterprise

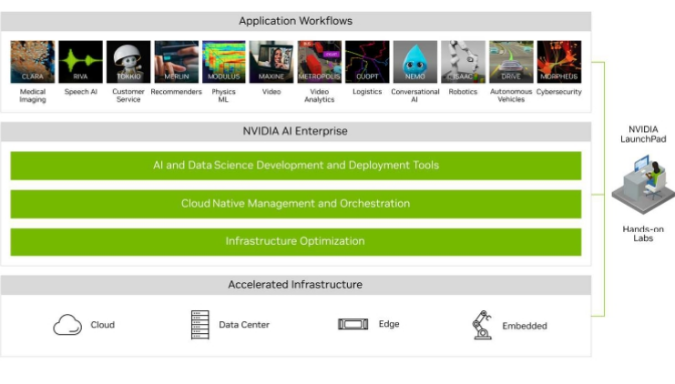

NVIDIA AI Enterprise — це комерційна платформа з підтримкою корпоративного рівня, яка дозволяє компаніям створювати, розгортати та управляти AI/ML-навантаженнями на інфраструктурах будь-якої складності: від локальних дата-центрів до хмари. Вона створена з фокусом на стабільність, безпеку, масштабованість та оптимізацію ресурсів. Платформа інтегрує понад 50 фреймворків, бібліотек і рішень NVIDIA, які прискорюють інновації в області комп’ютерного зору, обробки природної мови, генеративного ШІ та глибокого навчання.

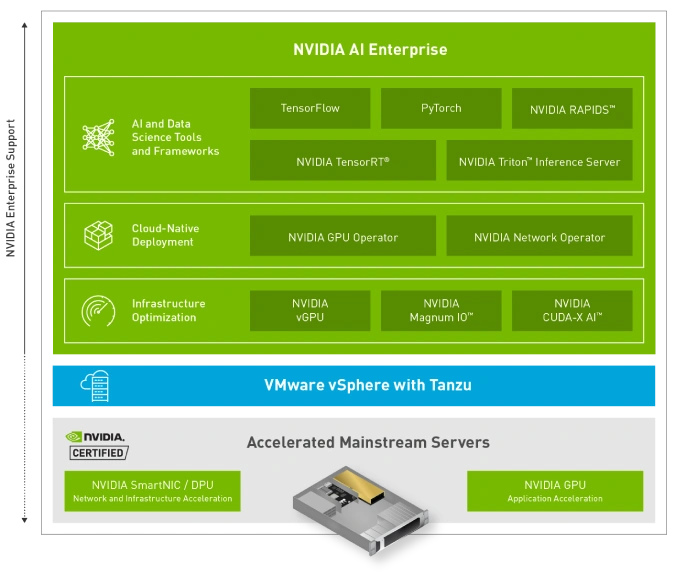

Серед її складових — драйвери NVIDIA для GPU, оптимізовані середовища виконання (наприклад, TensorRT чи Triton Inference Server), інструменти для роботи з контейнерами (NVIDIA Container Toolkit), бібліотеки RAPIDS для обробки даних, та численні приклади й SDK. Цей набір дозволяє компаніям суттєво знизити вартість розробки та скоротити час виходу на ринок. Завдяки інтеграції з платформами на кшталт VMware vSphere, Red Hat OpenShift та хмарними середовищами AWS, Azure, Google Cloud, AI Enterprise забезпечує безперебійну роботу в гібридних та мультихмарних сценаріях.

NVIDIA AI Enterprise активно розвивається як стратегічна частина корпоративної екосистеми NVIDIA, пропонуючи підтримку не лише технологій, а й технічної документації, оновлень безпеки, регулярних випусків та спеціалізованої підтримки. Це робить її привабливим вибором для команд, що працюють у сферах охорони здоров’я, фінансів, ритейлу, логістики та виробництва, де надійність й продуктивність AI-рішень мають першочергове значення.

Що таке NVIDIA AI Enterprise?

З технічної точки зору, NVIDIA AI Enterprise — це ліцензований програмний стек, що надає доступ до набору програмного забезпечення, оптимізованого для використання з GPU NVIDIA у віртуалізованих середовищах. У його основі лежить підтримка фреймворків TensorFlow, PyTorch, XGBoost, RAPIDS, а також попередньо зібраних контейнерів із Docker-репозиторію NVIDIA NGC (NVIDIA GPU Cloud). Це дозволяє розробникам і дата-саєнтистам запускати задачі навчання, інференсу та аналізу даних швидше та стабільніше, без складного налаштування оточення.

Ключовим елементом є інтеграція з корпоративними середовищами, зокрема з віртуалізаційною платформою VMware. Завдяки сертифікації VMware vSphere із NVIDIA vGPU можна розгорнути декілька ізольованих AI-інстансів на одному фізичному GPU, що значно покращує ефективність використання ресурсів. Інші підтримувані середовища Nvidia AI cloud включають Red Hat OpenShift, SUSE Rancher, Ubuntu, а також хмари Amazon EC2 G5, Azure NC, GCP A2.

Окрім самих компонентів, AI Enterprise включає обслуговування критичних для бізнесу функцій: SLA-рівень техпідтримки, оновлення безпеки, патчі, а також стабільні версії середовищ для продуктивної експлуатації. Це не просто набір бібліотек, а повноцінна платформа, яка дозволяє трансформувати AI-розробку в керований бізнес-процес.

Як працює NVIDIA AI Enterprise?

NVIDIA AI Enterprise функціонує як багаторівневий технологічний стек, який охоплює всі етапи життєвого циклу AI/ML — від підготовки даних до розгортання моделей у продуктивному середовищі. Основу платформи складають драйвери GPU, які забезпечують низькорівневу взаємодію з апаратним забезпеченням. Поверх цього шару функціонують бібліотеки CUDA, cuDNN та інші обчислювальні середовища, які дають змогу ефективно використовувати ресурси NVIDIA для тренування й інференсу моделей.

Інструменти для керування середовищем включають NVIDIA Docker Runtime, підтримку Kubernetes з GPU-оператором, інтеграцію з Red Hat OpenShift та Helm-чарти для швидкого розгортання компонентів. Компоненти, такі як Triton Inference Server, дозволяють виконувати високопродуктивний інференс із підтримкою декількох фреймворків одночасно, а також динамічне масштабування навантаження. Інструмент Triton підтримує такі можливості, як A/B-тестування моделей, маршрутизація запитів та моніторинг продуктивності за допомогою Prometheus та Grafana.

Для навчання моделей NVIDIA AI Enterprise пропонує інтеграцію з NGC Workspaces — середовищами розробки з попередньо налаштованими середовищами, де можливо запускати Jupyter Notebook, тренувати моделі на хмарній (Nvidia cloud AI) або локальній інфраструктурі, виконувати гіперпараметричну оптимізацію та експерименти. Під час запуску робочих навантажень у віртуалізованих середовищах, таких як VMware, можливо ефективно розподіляти ресурси GPU, що робить платформу придатною навіть для організацій із обмеженим апаратним фондом.

Огляд компонентів та функцій NVIDIA AI Enterprise

Архітектура NVIDIA AI Enterprise побудована навколо принципу модульності та оптимізації для продуктивного середовища. Серед основних компонентів платформи Nvidia AI варто виділити NVIDIA CUDA Toolkit — базову платформу для паралельних обчислень, яка забезпечує доступ до обчислювальних можливостей GPU. Інші важливі елементи включають cuDNN (глибоке навчання), NCCL (мережевий інтерфейс для розподілених обчислень), DALI (препроцесинг зображень), а також RAPIDS — набір бібліотек для роботи з даними в стилі pandas, але з апаратним прискоренням.

У сегменті інференсу платформу доповнює Triton Inference Server — потужний сервіс, здатний обробляти моделі, створені в TensorFlow, PyTorch, ONNX, XGBoost тощо. Його функціонал дозволяє обробляти запити в режимі реального часу, підтримує динамічне завантаження моделей, а також оптимізацію обчислень за допомогою TensorRT. Завдяки цьому інструменту можливо досягти мінімальної затримки відповіді при високому навантаженні без втрати точності моделей.

Для автоматизації розгортання NVIDIA пропонує Helm-чарти та GPU Operator, які дозволяють швидко та надійно інсталювати всі необхідні компоненти в Kubernetes-середовищі. Крім того, користувачі можуть скористатися готовими Docker-образами з NVIDIA NGC, які проходять регулярне тестування на сумісність та продуктивність. Це значно спрощує CI/CD-процеси, забезпечує відтворюваність середовищ та зменшує ризики, пов’язані з оновленнями.

У сфері обробки природної мови та комп’ютерного зору NVIDIA AI Enterprise включає в себе попередньо навчені моделі та SDK, зокрема TAO Toolkit для трансферного навчання, NeMo для роботи з мовними моделями та DeepStream для відеоаналітики. Ці інструменти орієнтовані як на дослідників, так і на інженерів, які прагнуть інтегрувати AI у свої програми без написання коду з нуля. Моделі можуть бути кастомізовані під конкретні бізнес-вимоги та легко адаптуються до нових датасетів.

Платформа також передбачає інтеграцію з провідними системами моніторингу та логування — Prometheus, Grafana, Fluentd, що дозволяє організаціям налагодити повний цикл спостереження за продуктивністю моделей і всієї AI-інфраструктури. Це критично важливо для дотримання вимог SLA та відповідності нормам безпеки.

Які переваги дає NVIDIA AI Enterprise для AI та ML?

Однією з ключових переваг NVIDIA AI Enterprise є її здатність зменшити технічну складність впровадження штучного інтелекту. Завдяки попередньо протестованим компонентам та сертифікованій інфраструктурі, ця платформа дозволяє суттєво знизити витрати на впровадження та прискорити час досягнення результату. Організації отримують доступ до інструментів, що працюють «із коробки», та можуть розпочати експерименти з AI-проєктами без глибоких знань DevOps або GPU-інфраструктури.

Для команд розробників та науковців велике значення має стабільність середовища. NVIDIA AI Enterprise забезпечує повторюваність результатів, контроль версій, підтримку сумісності компонентів та передбачуваність продуктивності. Це робить її зручною платформою як для етапу R&D, так і для масштабного продуктивного розгортання. Важливо також, що NVIDIA надає SLA-рівень підтримки, який критично важливий для організацій з високими вимогами до безперервності роботи сервісів.

Ще один вагомий плюс — масштабованість AI Nvidia. Платформа однаково добре підходить як для невеликих AI-проектів на одній машині, так і для розподілених задач на кластері GPU-серверів. Це дозволяє почати з малого, а потім розширювати ресурси без необхідності повністю змінювати стек. Інтеграція з VMware, Kubernetes і хмарами надає гнучкість, необхідну для сучасної AI-інфраструктури.

І, нарешті, важливою перевагою є доступ до екосистеми NVIDIA NGC: тисячі оптимізованих моделей, прикладів, інструментів і гайдів. Це не лише пришвидшує старт, а й дозволяє вчитися на прикладах, масштабувати знання команди та використовувати найкращі практики галузі.

Як почати працювати з NVIDIA AI Enterprise?

Перший крок — визначити тип інфраструктури, яку планується використовувати: локальна, віртуалізована або хмарна. NVIDIA Enterprise AI підтримує роботу як на baremetal-серверах, так й у віртуалізованих середовищах (VMware vSphere, Red Hat OpenShift), а також у публічних хмарах. Вибір середовища впливає на метод розгортання: у випадку з Kubernetes — через Helm-чарти; у VMware — через vSphere Plugin або vGPU-профілі.

Наступний етап — оформлення ліцензії NVIDIA AI Enterprise, що відкриває доступ до сертифікованих збірок, документації, сервісів підтримки та регулярних оновлень. Продукт можна придбати через авторизованих партнерів або безпосередньо в NVIDIA. Рекомендовано використовувати також портал NVIDIA LaunchPad — безкоштовне тестове середовище, де можна ознайомитися з можливостями платформи у форматі live demo.

Розгортання зазвичай починається з інсталяції драйверів, CUDA та необхідних бібліотек. Після цього — інтеграція з системами моніторингу, підготовка середовища CI/CD та інструментів для розробників (NGC CLI, JupyterHub, MLflow). Опціонально можна налаштувати механізми розподілу навантаження, тестування продуктивності та автоматичне масштабування моделей у Triton Server.

Після завершення базового налаштування команди можуть приступати до тренування власних моделей, або адаптувати готові з каталогу NGC. У разі потреби у підтримці — доступні консультації NVIDIA та спільнота користувачів. Таким чином, AI Enterprise — це платформа, яка не лише спрощує запуск, а й забезпечує повний життєвий цикл AI-рішень, від ідеї до впровадження. Компанії можуть швидко пройти шлях від дослідницького прототипу до масштабованої продуктивної системи з мінімальними ризиками та витратами на підтримку. Завдяки чіткому позиціонуванню в екосистемі корпоративного ШІ, вона стає надійною основою для цифрових трансформацій і довгострокового розвитку бізнесу.

Висновки

NVIDIA AI Enterprise це не просто технологічний продукт, а стратегічний інструмент для прискорення впровадження штучного інтелекту у бізнес-процеси. Завдяки гнучкій архітектурі, широкій підтримці фреймворків, сертифікації для провідних віртуалізаційних і хмарних платформ, вона суттєво знижує бар’єр входу в AI та дозволяє фокусуватися на створенні цінності, а не на інфраструктурних проблемах. Для компаній, що прагнуть бути на передовій технологічного розвитку, NVIDIA AI Enterprise пропонує стабільність, масштабованість і повноцінну підтримку на кожному етапі. Це рішення ідеально підходить для команд, які цінують контроль, продуктивність і довгострокову надійність у сфері штучного інтелекту.